Qual è il file Robots.txt in un dominio?

Strumenti Per I Webmaster Siti Web Seo Eroe / / March 19, 2020

Ultimo aggiornamento il

Uno dei maggiori errori per i nuovi proprietari di siti Web non è guardare nel loro file robots.txt. Allora, cos'è e perché è così importante? Abbiamo le tue risposte.

Se possiedi un sito Web e ti preoccupi della salute SEO del tuo sito, dovresti familiarizzare con il file robots.txt sul tuo dominio. Che ci crediate o no, si tratta di un numero inquietantemente elevato di persone che avviano rapidamente un dominio, installano un sito Web WordPress rapido e non si preoccupano mai di fare nulla con il loro file robots.txt.

Questo è pericoloso. Un file robots.txt mal configurato può effettivamente distruggere la salute SEO del tuo sito e danneggiare qualsiasi possibilità che tu possa avere per aumentare il tuo traffico.

Qual è il file Robots.txt?

Il robots.txt Il file ha un nome appropriato perché è essenzialmente un file che elenca le direttive per i robot web (come i robot dei motori di ricerca) su come e cosa possono eseguire la scansione sul tuo sito web. Questo è stato uno standard web seguito dai siti Web dal 1994 e tutti i principali crawler Web aderiscono allo standard.

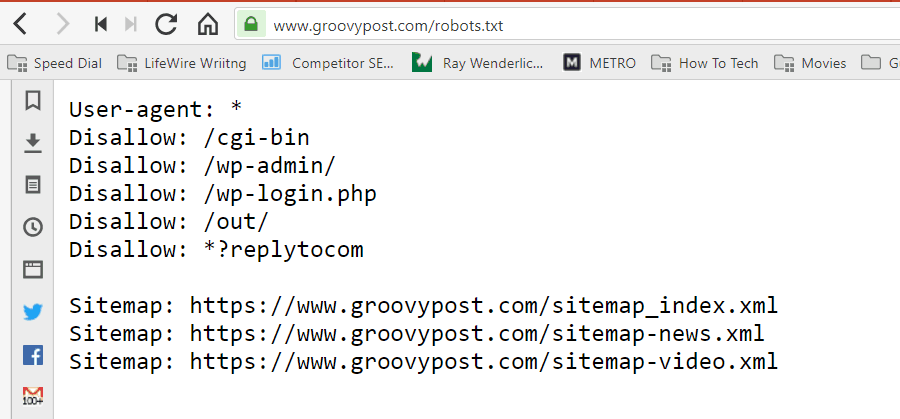

Il file è archiviato in formato testo (con estensione .txt) nella cartella principale del tuo sito web. In effetti, puoi visualizzare il file robot.txt di qualsiasi sito Web semplicemente digitando il dominio seguito da /robots.txt. Se lo provi con groovyPost, vedrai un esempio di un file robot.txt ben strutturato.

Il file è semplice ma efficace. Questo file di esempio non distingue tra robot. I comandi vengono inviati a tutti i robot utilizzando il User-agent: * direttiva. Ciò significa che tutti i comandi che lo seguono si applicano a tutti i robot che visitano il sito per eseguirne la scansione.

Specifica dei crawler Web

È inoltre possibile specificare regole specifiche per crawler Web specifici. Ad esempio, potresti consentire a Googlebot (il crawler web di Google) di eseguire la scansione di tutti gli articoli sul tuo sito, ma potresti voler impedire al crawler web russo Yandex Bot di eseguire la scansione di articoli sul tuo sito che contengono informazioni denigratorie Russia.

Esistono centinaia di crawler Web che cercano informazioni su siti Web in Internet, ma i 10 più comuni di cui dovresti preoccuparti sono elencati qui.

- Googlebot: Motore di ricerca di Google

- Bingbot: Motore di ricerca Bing di Microsoft

- bere rumorosamente: Motore di ricerca Yahoo

- DuckDuckBot: DuckDuckGo motore di ricerca

- Baiduspider: Motore di ricerca cinese Baidu

- YandexBot: Motore di ricerca russo Yandex

- Exabot: Motore di ricerca francese Exalead

- Facebot: Bot di scansione di Facebook

- ia_archiver: Crawler di ranking web di Alexa

- MJ12bot: Database di indicizzazione di collegamenti di grandi dimensioni

Prendendo lo scenario di esempio sopra, se volevi consentire a Googlebot di indicizzare tutto sul tuo sito, ma volevi farlo bloccare Yandex dall'indicizzazione del contenuto dell'articolo in base russo, aggiungere le seguenti righe a robots.txt file.

User-agent: googlebot

Non consentire: Non consentire: / wp-admin /

Non consentire: /wp-login.php

Agente utente: yandexbot

Non consentire: Non consentire: / wp-admin /

Non consentire: /wp-login.php

Non consentire: / russia /

Come puoi vedere, la prima sezione impedisce a Google di eseguire la scansione della pagina di accesso di WordPress e delle pagine amministrative. La seconda sezione blocca Yandex dallo stesso, ma anche dall'intera area del tuo sito in cui hai pubblicato articoli con contenuti anti-Russia.

Questo è un semplice esempio di come è possibile utilizzare rifiutare comando per controllare specifici crawler Web che visitano il tuo sito Web.

Altri comandi Robots.txt

Non consentire non è l'unico comando a cui hai accesso nel tuo file robots.txt. Puoi anche utilizzare uno qualsiasi degli altri comandi che indicheranno come un robot può eseguire la scansione del tuo sito.

- rifiutare: Indica all'utente-agente di evitare la scansione di URL specifici o di intere sezioni del sito.

- permettere: Consente di ottimizzare pagine o sottocartelle specifiche sul sito, anche se è possibile che non sia stata vietata una cartella principale. Ad esempio, è possibile non consentire: / about /, ma quindi consentire: / about / ryan /.

- Crawl-delay: Questo indica al crawler di attendere xx numero di secondi prima di iniziare a eseguire la scansione del contenuto del sito.

- Mappa del sito: Fornisci ai motori di ricerca (Google, Ask, Bing e Yahoo) la posizione delle tue Sitemap XML.

Tieni presente che i robot lo faranno solo ascolta i comandi che hai fornito quando specifichi il nome del bot.

Un errore comune che la gente fa è vietare aree come / wp-admin / da tutti i bot, ma quindi specificare una sezione googlebot e vietare solo altre aree (come / about /).

Poiché i robot seguono solo i comandi specificati nella loro sezione, è necessario riaffermare tutti gli altri comandi specificati per tutti i robot (utilizzando * user-agent).

- rifiutare: Comando utilizzato per indicare a un agente utente di non eseguire la ricerca per indicizzazione di un determinato URL. È consentita una sola riga "Non consentire:" per ciascun URL.

- Consenti (applicabile solo per Googlebot): Il comando per dire a Googlebot che può accedere a una pagina o sottocartella anche se la sua pagina principale o sottocartella potrebbe non essere consentita.

- Crawl-delay: Quanti secondi deve attendere un crawler prima di caricare e sottoporre a scansione il contenuto della pagina. Tieni presente che Googlebot non riconosce questo comando, ma la velocità di scansione può essere impostata in Google Search Console.

- Mappa del sito: Utilizzato per richiamare la posizione di una Sitemap XML associata a questo URL. Nota che questo comando è supportato solo da Google, Ask, Bing e Yahoo.

Tieni presente che robots.txt è pensato per aiutare i bot legittimi (come i motori di ricerca) a eseguire la scansione del tuo sito in modo più efficace.

Ci sono molti crawler nefasti là fuori che stanno eseguendo la scansione del tuo sito per fare cose come raschiare indirizzi e-mail o rubare i tuoi contenuti. Se vuoi provare a utilizzare il tuo file robots.txt per impedire a questi crawler di eseguire la scansione di qualsiasi cosa sul tuo sito, non preoccuparti. I creatori di quei crawler in genere ignorano tutto ciò che hai inserito nel tuo file robots.txt.

Perché non consentire nulla?

Fare in modo che il motore di ricerca di Google esegua la scansione del maggior numero possibile di contenuti di qualità sul tuo sito Web è una delle preoccupazioni principali per la maggior parte dei proprietari di siti Web.

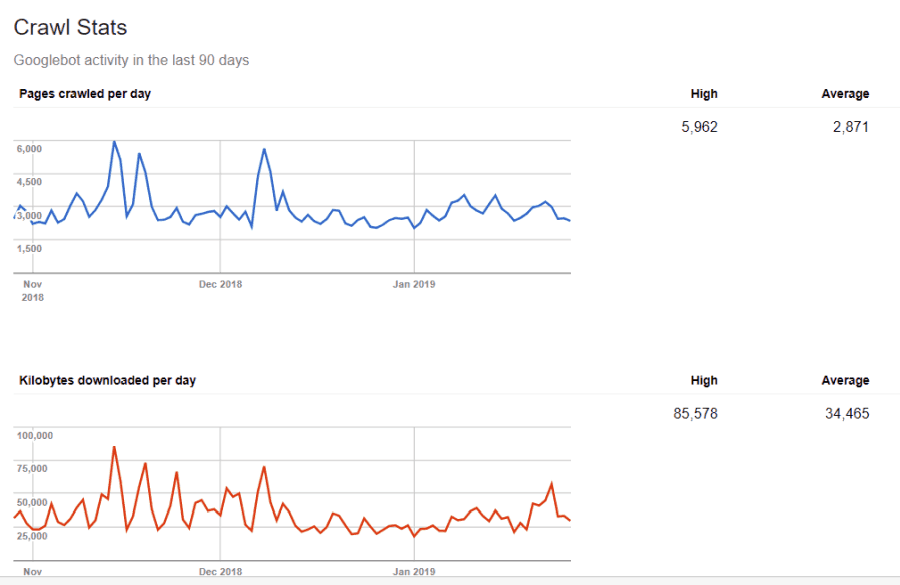

Tuttavia, Google spende solo un numero limitato budget per indicizzazione e velocità di scansione su singoli siti. La frequenza di scansione è il numero di richieste al secondo che Googlebot invierà al tuo sito durante l'evento di scansione.

Più importante è il budget di scansione, ovvero quante richieste totali Googlebot farà per eseguire la scansione del tuo sito in una sessione. Google "spende" il suo budget di scansione concentrandosi su aree del tuo sito che sono molto popolari o che sono cambiate di recente.

Non sei cieco a queste informazioni. Se visiti Strumenti per i Webmaster di Google, puoi vedere come il crawler gestisce il tuo sito.

Come puoi vedere, il crawler mantiene la sua attività sul tuo sito piuttosto costante ogni giorno. Non esegue la scansione di tutti i siti, ma solo quelli che considera i più importanti.

Perché lasciare a Googlebot decidere cosa è importante sul tuo sito, quando puoi utilizzare il tuo file robots.txt per dirgli quali sono le pagine più importanti? Ciò impedirà a Googlebot di perdere tempo con pagine di basso valore sul tuo sito.

Ottimizzazione del budget di scansione

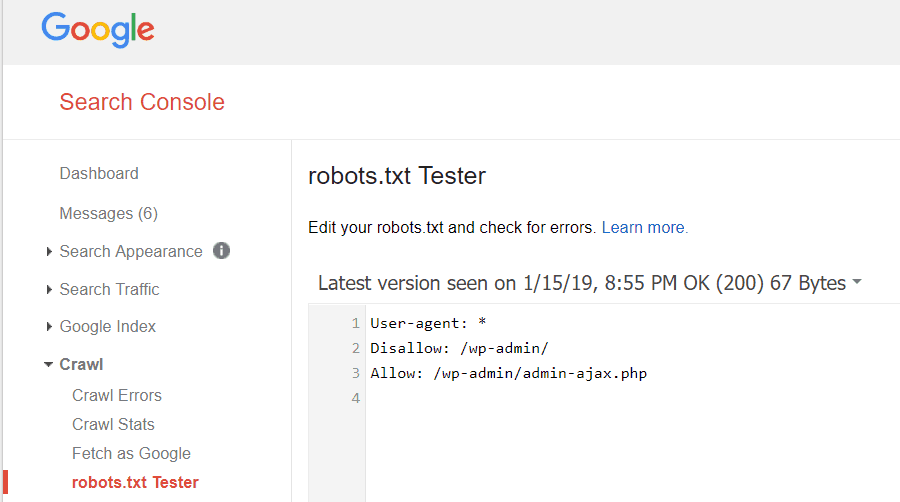

Strumenti per i Webmaster di Google ti consente anche di verificare se Googlebot sta leggendo il tuo file robots.txt e se ci sono errori.

Questo ti aiuta a verificare di aver strutturato correttamente il tuo file robots.txt.

Quali pagine dovresti impedire a Googlebot? È utile che il SEO del tuo sito non consenta le seguenti categorie di pagine.

- Pagine duplicate (come pagine stampabili)

- Grazie pagine che seguono gli ordini basati su moduli

- Moduli di richiesta informazioni o ordini

- Pagine di contatto

- Pagine di accesso

- Pagine di "vendita" con magnete al piombo

Non ignorare il tuo file Robots.txt

L'errore più grande che i nuovi proprietari di siti Web commettono non è nemmeno guardare il loro file robots.txt. La situazione peggiore potrebbe essere che il file robots.txt sta effettivamente bloccando la scansione del tuo sito o delle aree del tuo sito.

Assicurati di rivedere il tuo file robots.txt e assicurarti che sia ottimizzato. In questo modo, Google e altri importanti motori di ricerca "vedono" tutte le cose favolose che offri al mondo con il tuo sito web.